Machine Learning/scikit-learn

[이진 분류_성능 평가 지표] F1 스코어 / ROC곡선

ISLA!

2023. 9. 28. 15:01

💜 F1 스코어

- 정밀도와 재현율을 결합한 지표

- 정밀도와 재현율이 어느 한쪽으로 치우치지 않는 수치를 나타낼때 상대적으로 높은 값을 가짐 => 우수한 모델

- 사이킷런의 f1_score( ) API 사용

from sklearn.metrics import f1_score

f1 = f1_score(y_test, pred)

print('f1 스코어:{0:.4f}'.format(f1))f1 스코어:0.7759

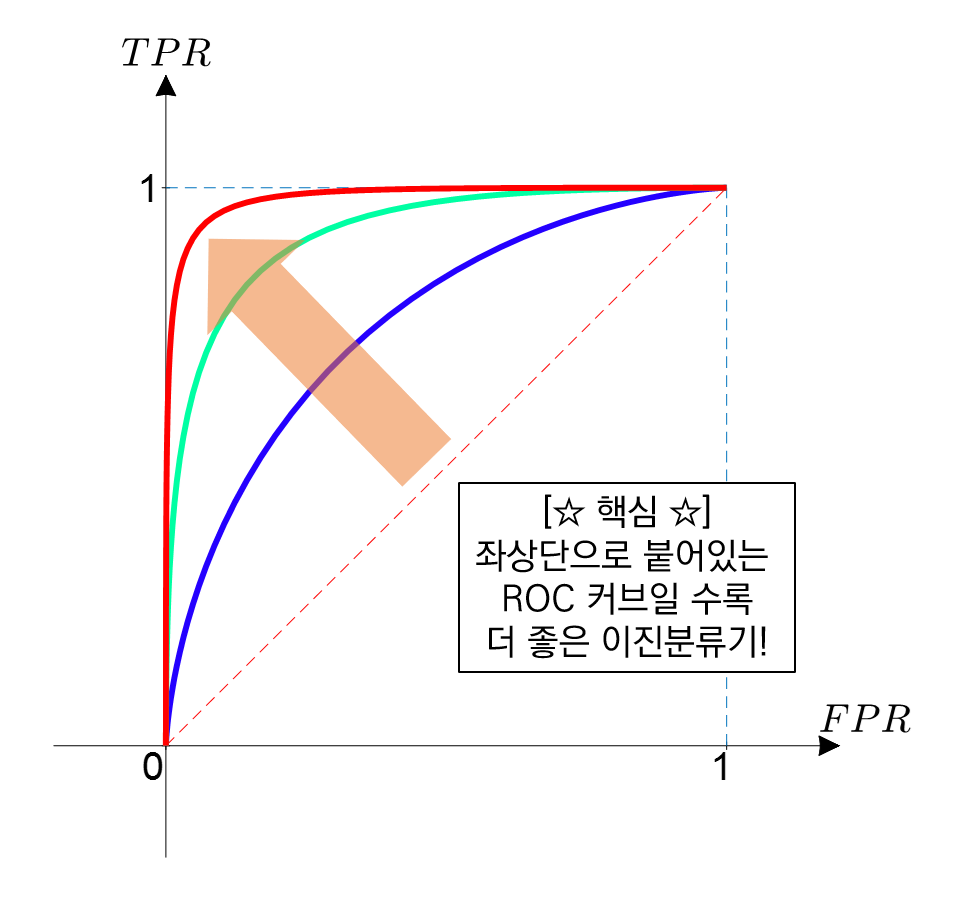

💜 ROC 곡선

- ROC 곡선과 이에 기반한 AUC 스코어는 이진 분류의 예측 성능에서 중요하게 사용되는 지표

- 분류의 성능 지표로 사용되는 것은 AUC : AUC 스코어는 곡선 밑의 면적으로, 1에 가까울 수록 좋다

- 일반적으로 ROC 곡선 자체는 FPR, TPR의 변화값을 보는 데 이용하며, 분류의 성능지표로 사용되는 것은 AUC 값(면적)

- 사이킷런의 roc_curve( ) 사용 : 반환값은 FPR, TPR, 임곗값

| 입력 파라미터 | y_true : 실제 클래스 값 array y_score : predict_proba()의 반환값 array에서 positive 칼럼의 예측 확률이 보통 사용됨 |

| 반환 값 | fpr : fpr 값을 array 로 반환 tpr : tpr 값을 array 로 반환 thresholds: threshold 값 array |

from sklearn.metrics import roc_auc_score

# 레이블 값이 1일 때의 예측 확률 추출

pred_proba_class1 = lr_clf.predict_proba(X_test)[:, 1]

# roc 커브 반환 값 확인

fprs, tprs, thresholds = roc_curve(y_test, pred_proba_class1)

- AUC 값 확인

from sklearn.metrics import roc_auc_score

# 레이블 값이 1일 때의 예측 확률 추출

pred_proba = lr_clf.predict_proba(X_test)[:, 1]

roc_score = roc_auc_score(y_test, pred_proba)

print('ROC AUC 값: {0:.4f}'.format(roc_score))ROC AUC 값: 0.8980

✅ 종합 함수 : 정확도, 정밀도, 재현율, F1 스코어, AUC 구하기

- 이전까지 작성한 함수에 ROC AUC 는 예측 확률값을 기반으로 계산되므로, 함수의 인자를 변경해줌

def get_clf_eval(y_test, pred=None, pred_proba=None):

confusion = confusion_matrix( y_test, pred)

accuracy = accuracy_score(y_test , pred)

precision = precision_score(y_test , pred)

recall = recall_score(y_test , pred)

f1 = f1_score(y_test,pred)

# ROC-AUC 추가

roc_auc = roc_auc_score(y_test, pred_proba)

print('오차 행렬')

print(confusion)

# ROC-AUC print 추가

print('정확도: {0:.4f}, 정밀도: {1:.4f}, 재현율: {2:.4f},\

F1: {3:.4f}, AUC:{4:.4f}'.format(accuracy, precision, recall, f1, roc_auc))728x90