회귀란?

- 통계학 용어로 회귀는 여러 개의 독립변수와 한 개의 종속변수 간 상관관계를 모델링하는 기법을 통칭한다

- 머신러닝 회귀 예측의 핵심은 주어진 피처와 결정 값 데이터 기반에서 학습을 통해 최적의 '회귀계수'를 찾는 것이다

✅ 회귀에서 가장 중요한 것은 회귀 계수이다. 회귀 계수의 선형 여부와 독립 변수의 개수에 따라 회귀의 유형을 구분한다

- 독립변수 1 개 : 단일 회귀 / 여러 개 : 다중 회귀

- 회귀 계수의 결합이 선형 : 선형 회귀 / 비선형 : 비선형 회귀

- 여러 회귀 중에, 선형 회귀가 가장 많이 사용된다

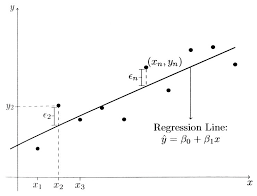

✅ 선형 회귀는 실제 값과 예측값의 차이를 최소화하는 직선형 회귀선을 최적화하는 방식이다

- 선형 회귀 모델은 규제 방법에 따라 다시 별도의 유형으로 나눌 수 있다.

- 규제는 일반적인 선형 회귀의 과적합 문제를 해결하기 위해 회귀 계수에 페널티 값을 적용하는 것이다.

대표적인 선형 회귀

- 일반 선형 회귀 : 예측 값과 실제 값을 RSS 최소화할 수 있도록 회귀 계수 최적화, 규제를 적용하지 않은 모델

- 릿지 : L2 규제를 선형 회귀에 추가. 상대적으로 큰 회귀 계수 값의 예측 영향도를 갑소시키기 위해 회귀 계수 값을 더 작게 만듦

- 라쏘 : L1 규제를 선형 회귀에 적용. 예측 영향력이 작은 피처의 회귀 계수를 0으로 만들어 회귀 예측 시 피처가 선택되지 않게 하는 것(따라서 피처 선택 기능으로도 불림)

- 엘라스틱 넷 : L2, L1 규제를 함께 결합한 모델. 주로 피처가 많은 데이터 세트에서 적용되며, L1 규제로 피처 개수를 줄임과 동시에, L2 규제로 계수 값의 크기를 조정

- 로지스틱 회귀 : 분류에 사용되는 선형 모델로, 매우 강력한 분류 알고리즘이다. 이진분류 뿐만 아니라 희소 영역의 분류(텍스트 분류 등)에서 뛰어난 예측 성능을 보임

단순 선형 회귀

- 독립변수도 하나, 종속변수도 하나인 선형 회귀

- 기울기와 절편을 회귀 계수로 지칭한다.

- 실제 값과 오류 값의 차 = 잔차(오류 값)

🧐 최적의 회귀 모델을 만든다는 것은?

- 전체 데이터의 잔차 합이 최소가 되는 모델을 만든다는 의미

- 오류 값 합이 최소가 될 수 있는 최적의 회귀 계수를 찾는다는 의미

잔차

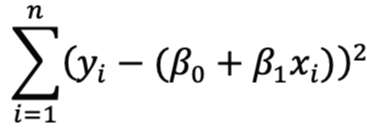

- 오류 값은 양수와 음수가 있을 수 있어, 오류 합을 계산할 때 절댓값을 취해 더하거나(MAE), 오류 값의 제곱을 구해서 더하는 방식(RSS)을 취함

- RSS는 비용이며, 회귀 계수로 구성되는 식을 비용 함수라고 한다.(또는 손실 함수라고도 함)

- 이 비용함수가 반환하는 값을 지속해서 감소시키고 최종적으로 더 이상 감소하지 않는 최소 오류 값을 구하는 것이다.

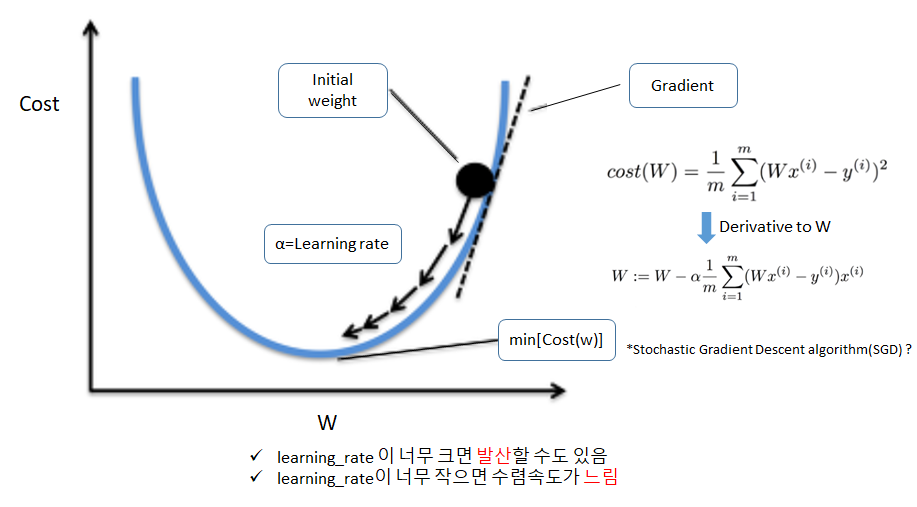

경사 하강법

- 어떻게 비용 함수가 최소가 될까? 라는 의문을 경사 하강법으로 해결할 수 있다.

- 경사 하강법은 데이터를 기반으로 알고리즘이 스스로 학습한다는 머신러닝의 개념을 가능하게 만든 핵심 기법의 하나이다.

- 딥러닝 기반인 신경망에서도 경사 하강법을 통한 학습을 수행한다.

728x90

'Machine Learning > scikit-learn' 카테고리의 다른 글

| [회귀] 선형회귀와 결정계수(R-squaured) (1) | 2024.02.12 |

|---|---|

| [이진 분류_성능 평가 지표] F1 스코어 / ROC곡선 (0) | 2023.09.28 |

| [데이터 전처리] One-Hot Encoding(원-핫 인코딩) (0) | 2023.09.27 |

| [데이터 전처리] Label encoding(레이블 인코딩) (0) | 2023.09.27 |

| [교차 검증] cross_val_score() (0) | 2023.09.26 |